Data Center: le architetture del digitale

Dalla progettazione tecnica alla sostenibilità, dalla sicurezza all’integrazione con il contesto paesaggistico: queste le sfide dei motori strategici della trasformazione digitale

Infrastrutture strategiche per lo sviluppo economico e tecnologico, i datacenter custodiscono il cuore digitale delle aziende e delle organizzazioni. Progettati per ospitare server per l’elaborazione e l’archiviazione delle informazioni e apparati di rete per la connettività, garantiscono che i dati e i servizi informatici siano sempre disponibili, sicuri ed efficienti. Per funzionare senza interruzioni, integrano impianti elettrici, climatizzazione, sistemi di sicurezza e connettività, in un ecosistema dove architettura e tecnologia lavorano in sinergia per assicurare continuità operativa ed efficienza energetica. Ed è proprio per queste specificità che la progettazione dei data center coinvolge diversi professionisti, uniti dalla ricerca verso l’innovazione e l’attenzione verso la sostenibilità.

“Nel mondo digitale in cui viviamo, i data center stanno assumendo un’importanza crescente: alimentano servizi cloud, intelligenza artificiale, streaming e comunicazioni globali – racconta Andrea Migliarese, senior architect di ARUP –. Dietro la loro efficienza tecnologica si nasconde però una realtà meno visibile: un impatto ambientale significativo, fatto di consumi energetici elevati, consumo di acqua, di suolo e di emissioni indirette. Ragione per cui negli ultimi anni, la sostenibilità dei data center e la loro integrazione nel contesto ambientale sono diventati temi centrali di riflessione per progettisti, investitori e pubbliche amministrazioni. Non si tratta soltanto di ridurre i consumi e di mitigare gli impatti negativi derivati da questi interventi, ma di ripensare l’intero ciclo di vita dell’edificio e il suo inserimento nel contesto, integrando architettura, impianti e strategie urbane con l’obiettivo di generare un impatto positivo sulle comunità locali attraverso processi circolari e virtuosi”.

A rendere il tema particolarmente vivo e attuale, la crescita senza precedenti del settore, alimentata principalmente dal rapido sviluppo dell’intelligenza artificiale che guida la richiesta di infrastrutture digitali per gestire grandi volumi di dati, come attesta il recente studio di JLL “Global Data Center Outlook”, che per il mercato Data Center stima una crescita annuale media del 15% a livello globale entro il 2027. In questo contesto l’Italia si sta affermando come uno dei mercati emergenti più dinamici in Europa, attirando investimenti significativi, come precisato da Barbara Cominelli, amministratrice delegata di JLL Italia: “Il mercato italiano dei data center sta attraversando una fase di grande trasformazione. Milano, in primis, e Roma sono al centro di questo sviluppo, con un forte interesse da parte di hyperscaler e investitori internazionali. L’Italia ha infatti tutte le carte in regola per diventare una geografia strategica nel complesso dell’infrastruttura digitale europea, a condizione che riesca a bilanciare crescita, sostenibilità e innovazione tecnologica, affrontando le sfide legate all’efficientamento energetico, all’adeguamento delle infrastrutture e al rispetto delle normative ambientali”.

Tra le sfide future evidenziate dallo studio JLL: una domanda che supera l’offerta e vincoli nello sviluppo e distribuzione dell’energia elettrica in alcuni mercati. Si legge infatti che “Secondo l’Agenzia Internazionale dell’Energia (AIE), la domanda globale di elettricità crescerà di circa il 4% nel 2025. Tuttavia, nonostante negli ultimi due anni le sfide energetiche siano state spesso collegate allo sviluppo dei data center, si stima che questa asset class rappresenterà solo il 2% del consumo globale di elettricità. Si prevede, infatti, che la domanda energetica dei data center potrebbe raddoppiare nei prossimi cinque anni, ma il suo impatto rimarrà relativamente contenuto rispetto ad altri settori, rappresentando meno di un terzo dell’aumento necessario per i veicoli elettrici e per il condizionamento dell’aria.

Va inoltre sottolineato che la realizzazione e gestione di data center sono soggette a un complesso quadro normativo, che include normative ambientali, urbanistiche, energetiche e di sicurezza, non di facile individuazione, in quanto allo stato non vi è una vera e propria normativa dedicata ai data center e, in fase autorizzativa e/o operativa, le istituzioni lavorano per assimilazioni, non sempre così calzanti e soprattutto non condividendo sempre il medesimo approccio, come evidenzia il box su “Aspetti Legislativi e Linee Guida nella Realizzazione e Gestione dei Data Center” a firma di Antonella Ceschi, partner dello studio legale Bird&Bird.

A seguire, un viaggio attraverso le priorità progettuali, le innovazioni emergenti e le strategie per costruire data center resilienti, scalabili e capaci di generare valore per le comunità e il territorio.

Le priorità progettuali

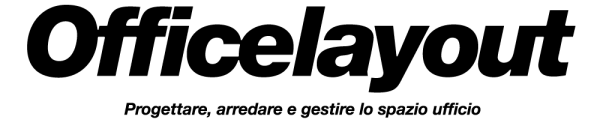

La progettazione dei data center richiede un approccio integrato, capace di trasformare requisiti tecnici e vincoli normativi in spazi architettonici efficienti e capaci di generare valore per comunità e paesaggi. La simmetria e la ridondanza degli impianti diventano principi architettonici, che disegnano spazi, soglie e proporzioni. I vincoli sono assoluti: continuità e ridondanza dei sistemi, sicurezza fisica e logica, efficienza energetica e termica, involucro edilizio protettivo, scalabilità modulare. Ne parla Pietro Matteo Foglio, founder e CEO di In-Site, che esprime una visione che lega ingegneria, architettura e responsabilità sociale: “Progettare un data center è come tracciare una mappa tra mondi che non si parlano: da un lato l’universo digitale, fatto di flussi di dati invisibili e potenze elettriche misurate al milliwatt, dall’altro il mondo fisico, con i suoi paesaggi, le sue comunità, i suoi equilibri naturali. È in questo territorio di confine che nasce la nostra disciplina: un’ibridazione consapevole tra la precisione dell’ingegneria e la sensibilità dell’architettura per i luoghi. Non si tratta solo di contenere macchine, ma di praticare quello che chiamiamo “umanesimo digitale”, cioè dare forma fisica al futuro tecnologico mantenendo sempre l’uomo al centro del progetto. I vincoli diventano, paradossalmente, le nostre opportunità creative più fertili. La necessità di controllare temperatura e umidità ci spinge a ricercare dialoghi inediti con il clima locale. I requisiti di sicurezza ci portano a inventare soglie e passaggi che proteggono senza isolare. Le esigenze di espansione ci sfidano a immaginare architetture che promuovano la rigenerazione urbana e garantiscano il non consumo di suolo, trasformando aree dismesse in nuove centralità digitali.

La nostra visione, radicata in oltre trent’anni di esperienza diretta nella progettazione di infrastrutture del digitale, prende ispirazione da quella di Adriano Olivetti: crediamo infatti, che anche un data center possa essere un gesto culturale, un’opera civile che arricchisce il contesto invece di impoverirlo. Ogni progetto è un ponte tra il virtuale e il fisico, una traduzione architettonica della rivoluzione digitale che non dimentica mai la propria responsabilità verso le comunità e i paesaggi che la ospitano”.

Sacha Busetti, COO mission critical infrastructures division di DBA Group, si inserisce nel dialogo, sottolineando gli aspetti tecnici e i vincoli legislativi che guidano la progettazione di queste architetture: “I principali driver progettuali di un data center possono essere sintetizzati in alcuni concetti chiave: affidabilità e continuità di funzionamento, robustezza e durabilità delle strutture, efficienza energetica, flessibilità e scalabilità, oltre alla sicurezza, che deve essere garantita sotto il profilo fisico, logistico e operativo. In sostanza, ogni data center ruota attorno a tre elementi cardine: energia, raffreddamento e sicurezza. L’architettura non è fine a se stessa, ma diventa il contenitore che assicura protezione ed efficienza agli impianti tecnologici ospitati. Accanto a questi principi, esistono vincoli di natura normativa, urbanistica e infrastrutturale. In Italia, ad esempio, manca ancora una destinazione urbanistica specifica per i data center: spesso vengono assimilati a edifici industriali o produttivi, secondo le regole del singolo comune, con parametri che non sempre corrispondono alle effettive esigenze costruttive. Un primo passo è arrivato nel 2024 dal Ministero dell’Ambiente e della Sicurezza Energetica, MASE, con l’emanazione di linee guida che hanno posto l’attenzione sull’impatto ambientale nella costruzione e gestione dei data center. Si tratta però di indicazioni e non di norme vincolanti. Parallelamente, nel giugno 2024, è stata presentata alla Camera una proposta di legge che punta a introdurre una disciplina specifica per questi centri, con procedure autorizzative semplificate, parametri definiti di efficienza e sicurezza, e un forte accento sulla formazione di competenze tecniche sia nel settore privato – per progettazione, sviluppo e gestione – sia nella pubblica amministrazione. A completare il quadro, restano cruciali i vincoli infrastrutturali, come la disponibilità di potenza elettrica in alta tensione e di connessioni in fibra ottica, senza i quali non è possibile garantire né la continuità né le performance richieste”.

Evidenzia gli aspetti più controversi del percorso progettuale Mattia Mariani, unit director building performance di Deerns Italia che tocca i temi del consumo rilevante di energia e di acqua, per arrivare all’impatto sociale sulla comunità: “L’energia utilizzata dai data center spesso proviene da fonti non rinnovabili, contribuendo così alle emissioni di CO2 (sia dirette in sito, per i gruppi elettrogeni, sia indirette per l’assorbimento elettrico) e al cambiamento climatico. Problematica che molte aziende stanno affrontando investendo su fonti di energia rinnovabile sia in sito sia fuori sito. Un altro aspetto critico è legato all’uso dell’acqua impiegata per il raffreddamento dei server un aspetto che spinge verso l’adozione di tecnologie di raffreddamento a circuito chiuso. Da non sottovalutare poi gli effetti che la costruzione e l’operatività dei data center possono avere sulle comunità locali, inclusi problemi di rumore, traffico dei mezzi da costruzione e uso del suolo. Impatti che possono essere mitigati coinvolgendo le comunità locali nei processi decisionali e implementando misure compensative, oltre a lavorare nella scelta del sito su siti già antropizzati (brownfield)”.

Dalla visione generale, alla definizione puntuale di vincoli e priorità, fino all’attenzione concreta verso l’architettura, tema affrontato da Andrea Migliarese di ARUP: “Fino ad oggi, seppur con interessanti eccezioni, la riflessione architettonica sui data center è rimasta piuttosto marginale e relegata a un’architettura tecnica spesso subordinata alle necessità impiantistiche. Il progetto architettonico del data center è infatti in primo luogo finalizzato alla realizzazione del contenitore destinato a proteggere il cuore impiantistico di queste vere e proprie “macchine” a scala urbana. In questo senso la progettazione planimetrica, la configurazione spaziale e le caratteristiche edilizie sono spesso vincolate dalla modularità dei server e dalle loro specifiche necessità, prima fra tutte quella di raffrescamento. Il progetto architettonico opera quindi all’interno di stringenti limitazioni tecniche cercando di sviluppare un disegno coerente che integri fra loro le diverse componenti impiantistiche. I campi privilegiati di intervento sono quelli del disegno delle facciate, delle aree esterne e della progettazione del verde, attraverso un lavoro di pulizia, semplificazione e riordino degli elementi. Se nella progettazione delle facciate questo si concretizza nella razionalizzazione delle componenti impiantistiche con lo sviluppo di un disegno coerente basato più sulla ricerca di una tessitura astratta di grandi campiture che sull’alternanza volumetrica di pieni e vuoti; nel disegno delle aree esterne, questo si traduce nella ricerca delle corrette disposizioni planivolumetriche dei volumi edilizi e nella sfumatura delle superfici orizzontali, così da evitare la formazione di ritagli residuali fra i flussi di distribuzione veicolare e gli edifici anche mediante una progettazione ricca del verde”.

L’involucro: elemento chiave per sicurezza, efficienza e integrazione con l’ambiente

Dietro ogni data center c’è un cuore pulsante di tecnologie, ma a renderne possibile il funzionamento è innanzitutto l’involucro edilizio. Non un semplice contenitore, bensì una “pelle” progettata per garantire protezione, efficienza energetica e resilienza. È la prima barriera contro incendi e agenti atmosferici, ma anche il filtro che permette di ridurre i consumi e migliorare il comfort termico degli ambienti interni.

Entra nel merito Matteo Foglio: “L’involucro di un data center non è più una barriera passiva: le facciate energetiche trasformano la pelle edilizia in superficie attiva, capace di produrre energia, regolare il microclima, contribuire alla sostenibilità complessiva dell’infrastruttura. La progettazione computazionale permette di simulare scenari complessi – dall’azione del fuoco agli shock termici – e di ottimizzare geometrie e materiali. Così la pelle diventa elemento di resilienza, ma anche linguaggio architettonico. In definitiva, possiamo affermare che l’involucro è il punto in cui ingegneria e architettura convergono: trasforma vincoli tecnici in identità, protezione in linguaggio, infrastruttura in architettura civile del digitale”.

Ma quali materiali costruttivi vengono scelti per la protezione da incendi, umidità, vibrazioni e interferenze elettromagnetiche? Ne parla Sacha Busetti: “Per la protezione dal fuoco delle parti strutturali, si prediligono elementi portanti in calcestruzzo armato, che raggiungono le prestazioni richieste mediante l’adozione di un adeguato copriferro, evitando materiali aggiuntivi e riducendo l’impatto in fase di costruzione e manutenzione.

L’involucro edilizio di un data center deve sempre essere progettato tenendo in considerazione le condizioni ambientali dell’area di intervento, le normative locali e il raggiungimento di una alta efficienza energetica. Facciate e coperture sono verificate per resistere a vento, neve e altri eventi atmosferici secondo le norme vigenti.

Per proteggere dall’umidità di risalita, in funzione delle caratteristiche del terreno e del livello della falda, si utilizzano impermeabilizzazioni tradizionali con guaine bituminose o sistemi innovativi come la “vasca bianca”, un cemento armato fondazionale additivato con resine speciali che lo rendono impermeabile all’acqua.

Per quanto riguarda le interferenze elettromagnetiche, l’attenzione principale è rivolta agli uffici e alle aree di lavoro con presenza continuativa delle persone che devono essere protette. Si privilegia il posizionamento di tali locali lontano da impianti che possano generare emissioni e, dove necessario, si possono adottare lamiere specifiche a schermatura. Tuttavia, nei locali con moduli finestrati, rispettare rigorosamente le soglie di legge risulta molto complesso”.

Tipologie e tendenze emergenti

È dagli anni ’90, con la diffusione dei server e delle reti locali che si usa il termine data center in ambito IT, ma nel corso dei decenni il concetto (e il progetto) di data center è evoluto, soprattutto dal 2000 in poi e con il contributo di colossi digitali come Google, Amazon e Microsoft.

Oggi i data center possono essere classificati in tre tipologie in base alle dimensioni e consumo energetico: Grande Hyperscale (oltre 9000mq >100MW); Medio (2000-9000mq >5MW) e Piccolo Edge 400-1800mq <5MW.

Inoltre, a seconda delle caratteristiche tecnico-strutturali e di business continuity, i data center possono essere classificati da TIER I a TIER IV. Più è alto il TIER maggiori sono le performance che la struttura può garantire (standard ANSI/TIA-942-A).

Non va poi dimenticata la differenziazione che ci può essere in termini di Power Usage Effectiveness (PUE di cui alla norma EN 50600-4-2), dato dal rapporto tra l’energia totale consumata dal data center e l’energia necessaria per l’hardware IT, la cui misura permette di migliorare il design e in generale l’efficienza complessiva del sistema. Pietro Matteo Foglio approfondisce: “Il mercato globale spinge sugli hyperscaler, ma in Italia non possiamo replicare modelli energivori e standardizzati. Serve una via italiana: sartoriale, distribuita, rigenerativa.

Con Nehos a Padova abbiamo dimostrato che rigenerare un capannone dismesso e trasformarlo in edge data center è possibile: alta densità, bassa impronta, integrazione con la città. Questo modello di prossimità può essere replicato in molti altri contesti, diventando strumento di rigenerazione urbana e di riduzione del consumo di suolo. La stessa logica apre oggi scenari ancora più ampi: il Sud Italia e il Mediterraneo. Sicilia, Calabria e Puglia sono approdi naturali dei cavi sottomarini e ponti verso Africa e Medio Oriente. Con Open Hub Med, di cui facciamo parte anche come soci, portiamo avanti l’idea di un Mediterraneo connesso e protagonista nella geografia digitale. A questo si aggiunge il tema della sovranità digitale europea. Gaia-X, con tutti i limiti di allora, aveva intuito il problema; oggi serve tradurlo in infrastrutture reali: “data residency by design”, reti distribuite e certificate che assicurino la permanenza dei dati europei in Europa.

Infine, la nuova generazione di edge data center ad alta potenza computazionale, collocati in prossimità delle fonti di energia rinnovabile – idroelettrico alpino, solare, eolico, geotermico, idrogeno – rappresenta un’opportunità unica per l’Italia: trasformare i suoi territori energetici in hub digitali.

Queste tendenze cambiano radicalmente l’approccio progettuale: ogni progetto diventa un ecosistema contestuale, che integra rigenerazione urbana, pianificazione energetica e prossimità digitale. È la sostanza di quello che chiamiamo umanesimo digitale: infrastrutture che custodiscono dati e al tempo stesso generano valore per comunità e paesaggi”.

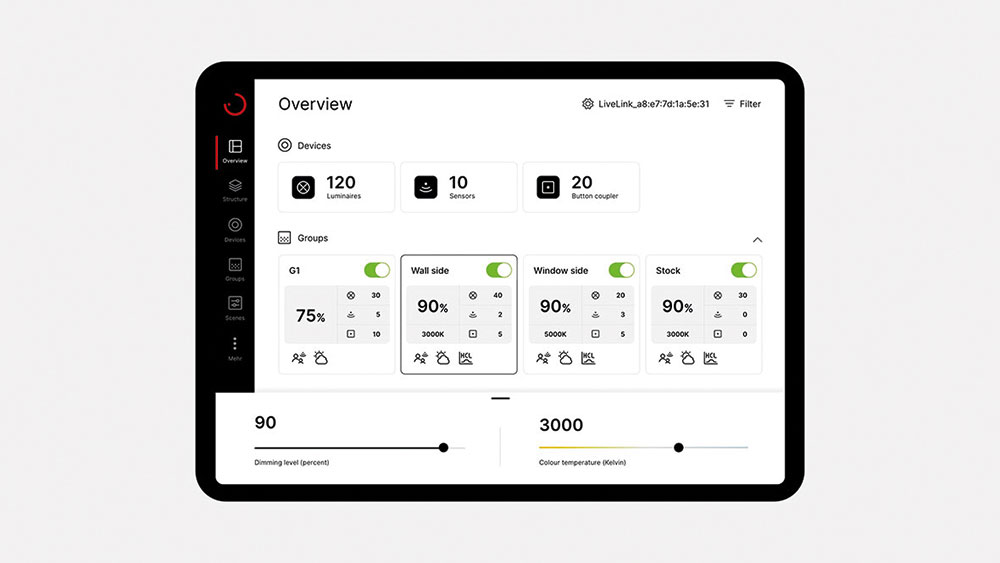

“La tendenza principale è l’aumento della densità di potenza di calcolo, che comporta una crescita significativa sia dei consumi elettrici sia della necessità di dissipazione termica – aggiunge Sacha Busetti –. La crescente domanda di applicazioni di Machine Learning ha già portato a densità superiori a 100 kW per rack, con progetti di macchine da 1 MW per rack in fase di sviluppo. Questi nuovi scenari impongono alcuni radicali cambi nelle scelte progettuali, soprattutto in tema di alimentazione elettrica e sistemi di condizionamento per i quali si stanno valutando alimentazioni in corrente continua con tensioni superiori a 500–600 V”.

In un percorso che va dal generale al particolare, Andrea Migliarese identifica tre principali fronti di innovazione. “In primo luogo si va verso l’integrazione di sistemi di raffreddamento a liquido ad alta efficienza, con tecnologie come il direct-to-chip cooling o il raffreddamento a immersione che permettono di operare a temperature più elevate (fino a 60 °C), migliorando al tempo stesso l’efficienza energetica, riducendo il fabbisogno di raffreddamento meccanico e facilitando il recupero del calore grazie a un controllo più preciso delle condizioni termiche. Inoltre, in un’ottica circolare particolarmente efficace nei contesti cittadini viene, cresce la realizzazione di heat-districts per il recupero del calore generato dai server, che può essere intercettato tramite scambiatori e riutilizzato direttamente o innalzato termicamente con pompe di calore per alimentare reti di teleriscaldamento urbane. Infine, l’implementazione di sistemi di monitoraggio energetico avanzato, basati su sottosistemi di metering intelligenti per energia, acqua e raffreddamento, che consentono di ottimizzare il funzionamento degli impianti, ridurre il PUE e individuare tempestivamente inefficienze o anomalie”.

Mattia Mariani, si inserisce nel dibattito confermando: “Le tecnologie di raffreddamento avanzato come il liquid cooling e l’immersion cooling stanno vedendo applicazioni sempre più estensive. Questi sistemi utilizzano un liquido per dissipare il calore generato dai server, che risulta un fluido (rispetto all’aria), molto più efficiente.

Inoltre, l’uso di fonti di energia rinnovabile, come l’installazione di pannelli fotovoltaici, è una misura per ridurre l’impatto in termini di consumo di energia e di emissioni. Tuttavia, dati gli elevati consumi di energia, le superfici richieste per gli impianti da fonti rinnovabili risultano molto importanti e spesso le aree disponibili in sito non sono sufficienti; di conseguenza occorre pensare anche di trovare spazi al di fuori sito per creare campi fotovoltaici. Infine, è essenziale coinvolgere le comunità locali nei processi decisionali relativi alla costruzione e all’operatività dei data center. Questo può includere consultazioni pubbliche, incontri informativi e la collaborazione con le autorità locali per garantire che le esigenze e le preoccupazioni della comunità siano adeguatamente affrontate”.

Obiettivo efficienza

Secondo le stime più recenti sviluppate da IEA, International Energy Agency, Barclays Research e Goldman Sachs Research il consumo di energia dei data center rappresenta fra l’1 e l’1,5% del consumo elettrico globale, con una proiezione di crescita fino al 3-4% entro fine decennio (Goldman Sachs). Cifre che stimolano il dibattito sulla ricerca di soluzioni in grado di ridurre l’impronta ambientale di un data center, fra consumi di energia e di territorio. Quali sono i metodi più efficaci? Risponde Andrea Migliarese: “La principale strategia è quella di ripensare il data center all’interno di una strategia urbana più ampia e non come intervento isolato, così da attivare con il contesto circostante processi circolari sinergici. In questa direzione, al di là delle soluzioni tecnologiche e impiantistiche menzionate, è auspicabile promuovere interventi pensati per accogliere attorno al data center lo sviluppo di altre funzioni mixed-use complementari, integrandolo all’interno di un più ampio intervento urbano e paesaggistico. In questa direzione, i proventi derivati dalla realizzazione del data center potrebbero essere investiti in progetti di mitigazione ambientale, divenendo l’occasione per interventi di ripristino di zone umide, di potenziamento del verde urbano, o di miglioramento del suolo e della vegetazione, così da promuovere un bilancio positivo per la biodiversità e contribuire agli obiettivi locali di resilienza ambientale. A questo proposito svolge un ruolo chiave la progettazione integrata per la resilienza climatica e la biodiversità, con l’integrazione di soluzioni nature-based (coperture verdi, fasce vegetate, sistemi SUDS) che migliorino la resilienza climatica del sito, riducano l’effetto isola di calore e contribuiscano in maniera positiva alla gestione sostenibile delle acque meteoriche. A livello dell’organismo edilizio, sono da ricercare strategie di ottimizzazione dell’involucro, sia con il ricorso a materiali a basso impatto con EPD e provenienza certificata, che mediante strategie di dematerializzazione (es. riduzione degli spessori di rivestimenti e strutture secondarie)”.

Certificazioni come garanzia di sostenibilità

Nel contesto della rapida crescita dei data center, le certificazioni ambientali diventano strumenti strategici: non solo garantiscono efficienza energetica e riduzione dell’impatto ambientale, ma guidano l’intero processo costruttivo verso scelte più sostenibili e responsabili, trasformando gli edifici tecnologici in modelli di innovazione e sostenibilità. Mattia Mariani ne evidenzia utilità e principi: “Alcune certificazioni rappresentano oggi uno standard essenziale per garantire la sostenibilità degli edifici, inclusi i data center. Nei Datacenter la domanda di certificazione sta aumentando, con i due protocolli LEED e BREEAM applicati dai diversi operatori con declinazioni differenti. LEED pone un forte accento sull’efficienza energetica e sulla gestione responsabile delle risorse, fornendo parametri per ridurre l’impatto ambientale dei data center. Il BREEAM pur valutando la sostenibilità dell’intervento, pone l’accento su altri parametri come l’ecologia, i rischi naturali e climatici, l’impatto acustico e il management del processo di progettazione e costruzione”.

Andrea Migliarese aggiunge: “La certificazione LEED applicata ai data center non si limita a valutare le prestazioni energetiche di un edificio, ma guida l’intero processo progettuale e costruttivo verso obiettivi ambientali concreti e misurabili. Dal punto di vista della progettazione, il percorso inizia con un approccio integrato: architetti, ingegneri e consulenti ambientali collaborano fin dalle prime fasi per ottimizzare l’efficienza energetica e idrica, scegliere materiali a basso impatto e prevedere sistemi di monitoraggio avanzato. Durante la costruzione, il cantiere diventa parte attiva della sostenibilità. LEED richiede un piano di gestione dei rifiuti, con obiettivi di recupero e tracciabilità mensile. La qualità dell’aria interna va tutelata anche in fase di lavori, evitando contaminazioni e proteggendo i materiali sensibili. Inoltre, è obbligatorio un piano di controllo dell’erosione e sedimentazione, con documentazione fotografica e misure preventive. Un altro elemento chiave è il commissioning: una figura terza, il Commissioning Authority, verifica che gli impianti siano installati e funzionanti secondo progetto, garantendo efficienza e affidabilità. Tutti questi requisiti devono essere integrati nei documenti di gara e nei capitolati, per assicurare che la sostenibilità non resti solo un’intenzione, ma diventi parte concreta del processo edilizio”.

Sicurezza fisica integrata

La sicurezza fisica dei data center costituisce la prima linea di difesa contro minacce tangibili come accessi non autorizzati, furti, disastri naturali o atti di vandalismo, proteggendo sia i dati che l’integrità delle infrastrutture e garantendo la continuità operativa. Questo obiettivo si realizza attraverso la progettazione di percorsi controllati, l’adozione di barriere strategiche e l’uso di zone buffer che separano gli spazi pubblici da quelli sensibili, assicurando un accesso rigorosamente regolamentato e sicuro.

“La sicurezza fisica di un data center si articola su più livelli, dal perimetro esterno del campus fino agli armadi rack nelle sale dati – spiega Sacha Busetti. Il primo livello è rappresentato dal perimetro esterno, solitamente delimitato da recinzioni ad alta sicurezza, progettate per resistere agli urti e risultare non scalabili, e sempre protette da videosorveglianza attiva 24/7. Gli ingressi sono controllati tramite guardiola, cancelli carrabili, tornelli con accesso tramite badge e i percorsi vengono distinti in base al tipo di utente (personale dedicato, fornitore, ospite).

Il secondo livello riguarda l’ingresso dell’edificio, presidiato da personale dedicato all’ufficio controllo accessi, anch’esso attivo 24/7. Il terzo livello include i locali critici che ospitano gli impianti fondamentali per il funzionamento continuo del data center e gli uffici amministrativi e operativi, accessibili tramite badge, biometria o impronta digitale, a seconda degli standard di sicurezza adottati.

Infine, il quarto livello è costituito dalle sale dati, dove sono collocati i racks e i dati veri e propri. L’accesso a queste aree è spesso regolato da sistemi che impediscono l’ingresso simultaneo di più persone con un solo badge o elemento di riconoscimento”.

Per In-Site, la sicurezza è linguaggio e struttura, non semplice requisito: il punto in cui ingegneria e architettura convergono per dare forma a un organismo resiliente, pensato per durare e per integrarsi nel paesaggio che lo ospita, come racconta Pietro Matteo Foglio con riferimento a uno dei progetti di punta realizzati da In-Site: “Intacture, è il primo data center ipogeo in Europa, collocato all’interno di una miniera attiva di dolomia nelle Dolomiti. Qui la sicurezza non è affidata a barriere artificiali, ma alla geologia stessa: cento metri di roccia che proteggono da eventi estremi, intrusioni, agenti atmosferici. La cava è organizzata in sezioni verticali che separano nettamente i flussi. Gli accessi, i sistemi di ventilazione e gli impianti sono distribuiti in maniera gerarchica, così da ridurre interferenze e vulnerabilità. Il fornello centrale diventa un vero e proprio dispositivo di sicurezza architettonico: governa lo scambio d’aria, consente evacuazioni ridondanti e, allo stesso tempo, controlla l’accesso ai diversi livelli. In questo contesto la sicurezza coincide con la forma stessa del progetto. L’infrastruttura non si limita a proteggere le macchine: diventa una fortezza contemporanea che custodisce i dati e, insieme, un’architettura civile capace di generare valore culturale e territoriale”.

Integrazione con il contesto

Dopo aver analizzato gli aspetti fondamentali di sicurezza fisica, efficienza energetica e soluzioni costruttive dei data center, emerge l’importanza di considerare anche la loro integrazione nel contesto urbano e paesaggistico. Un approccio progettuale attento permette di armonizzare funzionalità tecnologica, efficienza operativa ed estetica, riducendo l’impatto visivo, valorizzando il tessuto urbano e promuovendo un inserimento rispettoso dell’ambiente circostante.

“Il data center non va considerato soltanto come un ‘bunker di server’, ma come un vero e proprio edificio tecnologico urbano. Dato il suo volume e l’imponenza degli impianti, è fondamentale studiarne l’inserimento nel contesto urbano e nel paesaggio. L’architettura ha il compito di mitigarne l’impatto visivo e armonizzarne la presenza con l’ambiente circostante”, conferma Mattia Mariani che così continua: “Le strategie di mitigazione principali includono il trattamento delle facciate con rivestimenti contemporanei e tecnologici o con seconde pelli vegetali, la schermatura degli impianti sulla copertura o nei cortili esterni (gruppi frigo e gruppi elettrogeni) mediante barriere metalliche gradevoli che possano anche ridurre il rumore, e l’intervento sul paesaggio naturale nelle aree esterne al perimetro del campus, prevedendo fasce alberate a barriera visiva e bacini o laghetti artificiali utili anche alla gestione delle acque”.

Chiave di un corretto inserimento nel territorio e di una contestuale efficienza e ottimizzazione del funzionamento è, secondo Andrea Migliarese, il dialogo con figure professionali fra loro complementari: “Solo attraverso una progettazione realmente integrata e una costante collaborazione interdisciplinare è possibile superare le criticità del coordinamento, realizzando data center che siano al contempo altamente performanti dal punto di vista tecnico e di qualità dal punto di vista architettonico”.

Scalabilità, espansione e visione futura

Nella progettazione dei data center, la capacità di adattarsi alle esigenze future rappresenta un elemento cruciale. Scalabilità ed espandibilità non riguardano solo l’aumento della capacità dei server o dello storage, ma coinvolgono l’intera infrastruttura, dalla distribuzione energetica ai sistemi di raffreddamento, garantendo che il centro dati possa crescere e innovare senza compromettere efficienza, sicurezza o sostenibilità. In che modo la progettazione tiene in considerazione l’espandibilità futura?

“Per anni i data center sono stati interpretati anche come asset immobiliari, con logiche vicine al settore del real estate. Oggi la prospettiva si è ampliata: l’espansione viene letta come occasione per generare ecosistemi digitali che producono valore condiviso e rafforzano i territori. L’espandibilità si traduce nella creazione di cluster digitali che convivono con centri di ricerca, poli universitari e spazi multifunzionali, dando vita a vere e proprie comunità digitali. È un’evoluzione qualitativa: il data center non cresce solo in potenza, ma diventa nodo di una rete che integra innovazione, formazione e produzione energetica. In questa prospettiva il principio guida diventa quello dell’economia circolare: recupero di calore e risorse, riuso di strutture esistenti, simbiosi industriale con le filiere produttive. Il data center si afferma così come catalizzatore di rigenerazione urbana e ambientale, oltre che digitale. È la visione che In-Site porta avanti nei progetti più recenti: infrastrutture distribuite e scalabili, capaci di costituire nuove centralità urbane e territoriali, in coerenza con la strategia europea della twin transition verde e digitale. In questo senso, l’espandibilità è un principio culturale oltre che tecnico: i data center crescono per costruire ecosistemi circolari di conoscenza, energia e comunità”. Concretamente, per In-Site il futuro disegna data center ‘upper edge’, collocate sui tetti delle città, non come aggiunta ma come nuova stratificazione urbana, dialogando con fotovoltaico, micro-eolico e orti urbani, per città più sostenibili e interconnesse.

Mantenendo un piano pratico, DBA collega il concetto di espandibilità con quello della potenza di calcolo installabile: “Spesso si predispone fin dall’inizio una maggiore capacità di raffreddamento e alimentazione rispetto alle necessità del ‘giorno 1’ – aggiunge Sacha Busetti –. Dal punto di vista architettonico, la progettazione modulare e le strategie di collegamento e connessione degli spazi giocano un ruolo cruciale nel definire le potenzialità di espansione futura, garantendo al contempo il mantenimento delle funzionalità operative e dei requisiti di sicurezza fisica”.

Aspetti Legislativi e Linee Guida nella Realizzazione e Gestione dei Data Center

A cura di Antonella Ceschi, partner dello studio legale Bird&Bird

La crescente domanda di infrastrutture digitali ha reso i data center elementi strategici per lo sviluppo economico e tecnologico. Tuttavia, la loro realizzazione e gestione sono soggette a un complesso quadro normativo, che include normative ambientali, urbanistiche, energetiche e di sicurezza, non di facile individuazione, in quanto allo stato non vi è una vera e propria normativa dedicata ai data center e, in fase autorizzativa e/o operativa, le istituzioni lavorano per assimilazioni, non sempre così calzanti e soprattutto non condividendo sempre il medesimo approccio.

Il Quadro Normativo Italiano ed Europeo

A livello comunitario, il regolamento europeo DORA (Digital Operational Resilience Act) introduce obblighi specifici per la resilienza operativa digitale, con impatti diretti anche sui fornitori di servizi ICT critici, inclusi i data center. Il regolamento prevede infrastrutture ICT sicure e resilienti, audit e supervisione per i fornitori terzi, e gestione del rischio ICT e della continuità operativa che ovviamente devono essere tenuti presenti in fase di progettazione, realizzazione e successivamente devono fare oggetto di monitoraggio in fase operativa.

A livello nazionale, attualmente non esiste una normativa specifica in tema di data center, anche se è in fase di esame un disegno di legge che ha raccolto varie proposte, proprio finalizzato a dare ordine alla materia.

In attesa di una normativa specifica, con il Decreto n. 257 del 2 agosto 2024, il MASE ha adottato nuove linee guida per la valutazione ambientale dei progetti di data center. Queste includono lo Studio di Impatto Ambientale (SIA), lo Studio Preliminare Ambientale (SPA), la verifica delle migliori tecnologie disponibili (BAT), la gestione delle emissioni, rifiuti, rumore, acque reflue e impatti paesaggistici, misure di mitigazione e compensazione ambientale, e il Piano di Monitoraggio Ambientale (PMA), oltre a dare indicazioni per quanto riguarda le autorizzazioni ambientali, tema critico e cruciale per la progettazione e realizzazione di un data center.

Proprio su questo ultimo piano, va considerato come le stesse Linee Guida sottolineino che la Valutazione di Impatto Ambientale (VIA) è uno strumento fondamentale per garantire che i progetti di data center siano compatibili con l’ambiente circostante. Le Linee Guida in particolare prevedono screening VIA, VIA completa, analisi unitaria e contestuale, valutazione degli impatti cumulativi e integrazione con l’Autorizzazione Integrata Ambientale (AIA), autorizzazione che interviene in caso di impianti complessi per integrare e superare l’AUA.

Più nel dettaglio le Linee Guida devono essere lette in coordinamento con le SNPA 28/2020 e identificano i principali aspetti progettuali da considerare in sede di Screening VIA o VIA completa:

- Aspetti ambientali e sanitari: qualità dell’aria, rumore, emissioni in atmosfera, gestione degli scarichi idrici, rifiuti.

- Aspetti progettuali e tecnici: layout dell’impianto, consumo energetico, sistemi di raffreddamento, ridondanza e continuità operativa.

- Tutela ecologica e biodiversità: impatti su habitat naturali, fauna e flora.

- Rischi esogeni e accidentali: eventi climatici estremi, incendi, blackout.

- Paesaggio e beni culturali: inserimento paesaggistico, visibilità, impatto su aree vincolate.

- Impatto cumulativo: in particolare nei campus data center con più operatori.

- Misure di mitigazione e compensazione: sia ambientali che sociali.

- Decommissioning e restauro ecologico: obblighi post-operativi.

- Piano di monitoraggio ambientale: indicatori, frequenze, responsabilità.

È inoltre ribadito il divieto di frazionamento artificioso dei progetti per eludere la VIA, e l’obbligo di valutazione unitaria per opere complesse

La sopra indicata elencazione evidenzia come in fase progettuale e, successivamente in quella realizzativa così come in quella operativa, tanti siano gli aspetti da attenzionare, in quanto banalmente la scelta tecnica di come provvedere al raffrescamento delle macchine tema cruciale quando si parla di data center, deve tenere conto del rumore prodotto, degli impatti sull’aria, sull’acqua e sull’ambiente circostante persino da un punto di vista visivo.

Si segnala infine come la Regione Lombardia con la Delibera XII/2629 del 24/06/2024 abbia a sua volta approvato le Linee guida per la localizzazione, costruzione e gestione dei data center, pubblicate nel BURL. L’obiettivo era fornire ai Comuni e agli operatori un quadro uniforme per affrontare le richieste autorizzative, superando le incertezze normative e la discrezionalità locale.

Senza entrare nel merito del loro contenuto che, per esempio individua una destinazione d’uso più compatibile, da tenere presente evidentemente in sede di localizzazione, la Regione opera una classificazione dei data center in base alla potenza e, in particolare, in base alla potenza termica dei gruppi elettrogeni, distingue il tipo di procedura ambientale applicabile.

Anche altre regioni italiane, come la Puglia, stanno avviando tavoli tecnici per definire linee guida locali. Questo riflette una crescente attenzione alla pianificazione territoriale e alla sostenibilità ambientale anche a livello sub-nazionale.

In conclusione, la gestione delle autorizzazioni ambientali necessarie per realizzare e gestire un data center, richiede pianificazione anticipata, il coordinamento con gli enti locali, una documentazione tecnica dettagliata e una maggiore attenzione nel caso in cui lo sviluppo sia previsto nell’ambito di un campus multi-operatori.